在監控模型飄移(Model Drift)的方法中, KL 散度(Kullback-Leibler Divergence)與 JS 散度(Jensen-Shannon Divergence)可用來偵測是否發生資料飄移(Data Drift),兩者都是以信息熵(Information Entropy)為基礎做定義,皆可作為度量兩個機率分佈 P 與 Q 相似度的一種統計距離(Statistical Distance)。兩者最大的差別在於, KL 散度不具有距離尺度的對稱性(Symmetric), KL 散度不為距離尺度,然而, JS 散度彌補了 KL 散度的對稱性且為一距離尺度。

範例說明:

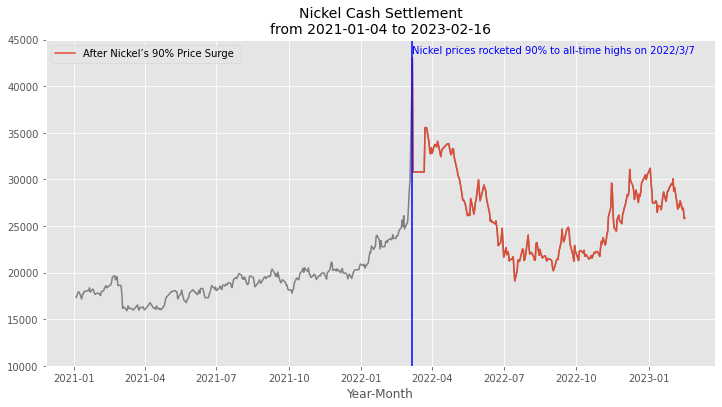

數據飄移的偵測結果:

在去(2022)年 3月初鎳的交易市場中,發生了前所未見的暴漲,市場將此事件稱為「妖鎳事件」。本範例將應用 2021 年起每個交易日的鎳現金結算數據,且使用 KL 散度與 JS 散度來觀察鎳的交易市場,在事件前後的資料是否產生明顯的偏移現象?

Back to How to Detect Model Drift?